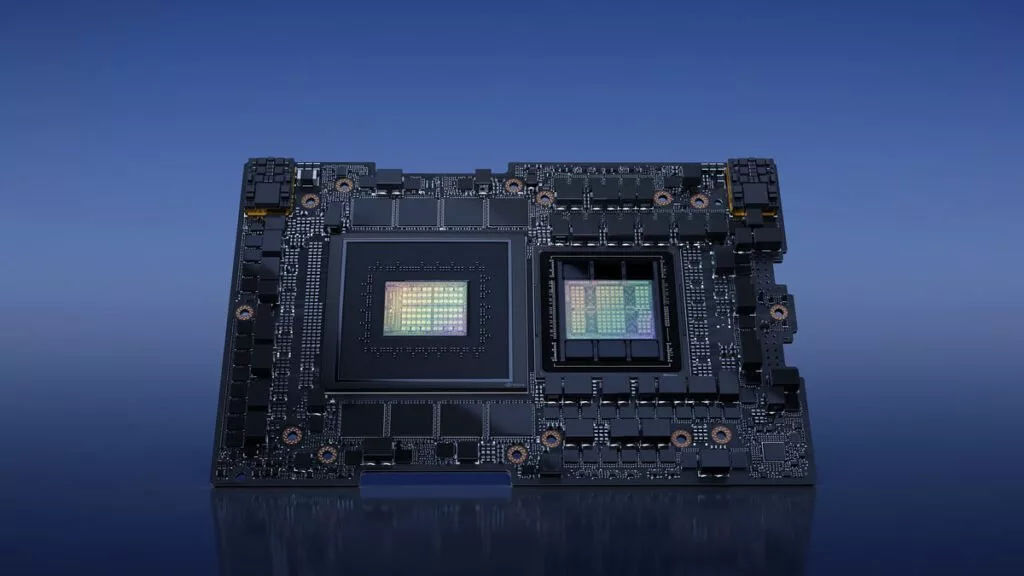

جدیدترین تراشه هوش مصنوعی انویدیا با نام GH200 سرعت بالاتری دارد و ظرفیت حافظه بیشتری را در اختیار کاربر میگذارد.

انویدیا درحالحاضر بزرگترین بازیگر بازار پردازندههای هوش مصنوعی است. این شرکت حالا از نسل بعدی پردازنده AI خود با نام انویدیا GH200 رونمایی کرده که سرعتی بالاتر خواهد داشت و ظرفیت حافظه آن سهبرابر بیشتر از پردازنده H100 خواهد بود.

انویدیا از ابرتراشه جدیدی به نام GH200 پرده برداشته است که میتواند پیچیدهترین کارهای مربوط به هوش مصنوعی مولد در مدلهای زبانی بزرگ، سیستمهای پیشنهادگر و پایگاههای داده وکتور را انجام دهد. پردازشگر گرافیکی این تراشه تفاوتی با H100 ندارد، اما ظرفیت حافظه آن سهبرابر شده است.

معرفی تراشه هوش مصنوعی انویدیا GH200

این پلتفرم از ابرتراشه Grace Hopper استفاده میکند که میتواند به تراشههای NVIDIA NVLink متصل شود. این فناوری پرسرعت و یکپارچه به GPU اجازه میدهد که دسترسی کاملی به حافظه CPU داشته باشد. در این تراشه از حافظه جدید HBM3e استفاده شده که ظاهراً 50 درصد سریعتر از حافظه HBM3 است. انویدیا میگوید پهنای باند ترکیبی این تراشه تا 10 ترابایت بر ثانیه خواهد بود.

انویدیا میگوید سرورها در فصل دوم سال 2024 به تراشه GH200 مجهز میشوند. این شرکت هنوز درباره قیمت این محصول جدید حرفی نزده است.

«جنسن هوانگ»، مدیرعامل انویدیا میگوید: «پلتفرم ابرتراشه GH200 Grace Hopper فناوری حافظه و پهنای باند خارقالعادهای دارد که توان خروجی را بهبود میدهد، قابلیت اتصال GPUها به یکدیگر برای تجمیع توان بدون هدررفت قدرت را بالاتر میبرد و طراحی سروری ارائه میکند که میتواند بهراحتی در سرتاسر یک دیتاسنتر کامل پیادهسازی شود.»

مدلهای پیشرفته هوش مصنوعی نیازمند GPU قدرتمندی هستند تا سیستم بتواند پردازشهای لازم برای تولید متن یا تصویر را انجام دهد. اجرای این مدلها مستلزم قدرت پردازشی بالاست و حتی با استفاده از تراشههای H100، برخی شرکتها ترجیح میدهند که مدلهای خود را روی پردازشگرهای گرافیکی گوناگون قرار دهند تا مشکلی در اجرای آنها بهوجود نیاید.

انویدیا در بازار پردازشگرهای گرافیکی هوش مصنوعی مولد تقریباً انحصار ایجاد کرده است. بسیاری از شرکتهای ارائهدهنده خدمات ابری مثل آمازون، مایکروسافت و گوگل همگی از تراشه H100 این شرکت استفاده میکنند و به انویدیا وابستهاند.